Einleitung

Mit einer modernen BI und Analytics Lösung wollen wir Datenprozesse automatisieren und die Organisation befähigen effektiv(er) und effizienter mit den vorhandenen Daten zu arbeiten. Damit das gelingt müssen wir eine Lösung bzw. eine Plattform aufbauen, welche die heute bekannten sowie die noch unbekannten spezifischen Anforderungen des Unternehmens flexibel erfüllen kann. Eine moderne BI Plattform (bzw. Architektur) besteht dabei aus vielen technischen und organisatorischen Elementen, die ineinandergreifen müssen.

Unabhängig vom spezifischen Unternehmen und Use-Case, gibt es wichtige Faktoren, die uns helfen solch ein Projekt zum Erfolg zu führen. Diese Erfolgsfaktoren finden sich insbesondere auf der organisatorischen Ebene und meist sogar in der Unternehmenskultur. Wenn wir diese ausser Acht lassen, kann die eingesetzte Technologie noch so gut und modern sein, wir werden vermutlich mit unserem Vorhaben mittel- oder langfristig scheitern.

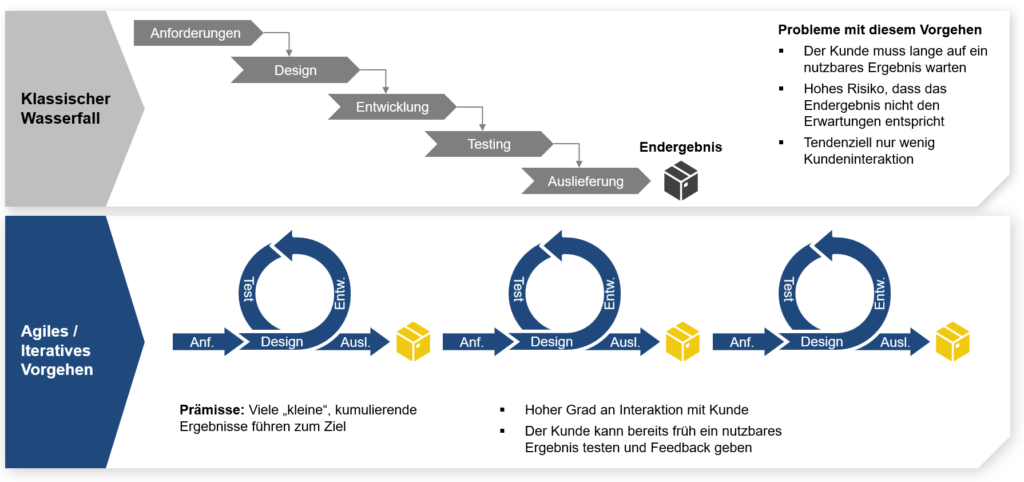

Realistischer Scope und iteratives Vorgehen

Wird der Scope insbesondere zu Beginn eines Projekts zu weit gefasst, führt das schnell zu einer Verzettelung, Ineffizienz und auch Überforderung im Team. Vieles ist begonnen, nichts ist abgeschlossen oder bereit für echte, vertiefte Tests. Ein erster operativer Betrieb der Lösung verschiebt sich weiter, weil das Erarbeitete keiner richtigen Validierung standhält. Die Feedbacks der Nutzer sind entsprechend negativ.

Ein realistischer Scope bedeutet fast immer weniger ist mehr. Eine konkrete Handlungsempfehlung ist, das BI Projekt mit einer oder maximal zwei Kennzahlen, welche wir nach zwei bis drei Dimensionen auswerten wollen, zu beginnen. Im Finanzumfeld ist das typischerweise der Umsatz, ausgewertet z.B. nach Datum, Produkt und Kunde. Mit diesen Anforderungen können wir den ersten ETL-Prozess, das erste Datenmodell und das erste Dashboard erstellen. Der Scope ist zwar klein, aber wir haben bereits früh ein funktionierendes System.

Es empfiehlt sich entsprechend auch dieses erste Lieferergebnis möglichst bald in einen operativen Betrieb zu überführen und die Nutzer damit arbeiten zu lassen. Damit erzielen wir frühzeitig “Lessons Learned” und verstehen die Anforderungen der Nutzer immer besser. Und ab hier entwickeln wir die Lösung stetig und iterativ weiter, indem wir Feedbacks wahrnehmen und laufend in den Entwicklungsprozess integrieren. Das ist echtes agiles Vorgehen.

Agiles Vorgehen der DataVision

Komplexität unter Kontrolle halten

Mit einer BI Lösung implementieren wir primär ein Automatisierungssystem. Wir automatisieren den Datenfluss von der Datenquelle bis zur dynamisch auswertbaren Kennzahl im Dashboard. Und Automatisieren bedeutet wir müssen eine durchgängige Logik auf die Daten anwenden können. Beginnen wir nun mehr und mehr Ausnahmen in diese Logik einzubauen auf einem immer tieferen Detailniveau, erhöhen wir die Komplexität des Systems zunehmend. Meist ist es dann auch so, dass sich Kernaussagen und Informationen aus dem BI nur noch marginal verändern. Die 80:20-Regel ist deshalb auch im Analytics-Umfeld sehr relevant.

Eine zunehmende Komplexität im BI verursacht leider in vielfacher Hinsicht Kosten: Einerseits müssen wir heute die Logik komplizierter entwickeln. Andererseits wird die Gesamtlösung zunehmend weniger robust, was sich in einem erhöhten Unterhaltsbedarf niederschlagen wird. Und zu guter Letzt ist es bedeutend aufwändiger morgen Änderungen und Erweiterungen an einer komplexen Lösung vorzunehmen.

Konkret lohnt es sich komplizierte Anforderungen oder Change Requests (Änderungswünsche) aus der Organisation zu hinterfragen und sich den Folgewirkungen bewusst zu sein: Lohnt sich das wirklich? Ist die zweite Kommastelle im Deckungsbeitrag wirklich so wichtig für unser Unternehmen? Oder gibt es nicht doch sinnvollere Erweiterungen für unser BI?

Interaktive Datenanalyse und Self-Service statt statische Berichte

Moderne, marktführende BI Tools wie Power BI erlauben ein hochgradig interaktives Arbeiten mit den Daten. Ich kann per Mausklick Filtern, auf tiefere Details drillen oder Werte schnell hochverdichten. Selbst komplexe Berechnungen werden dabei dynamisch und blitzschnell ausgewertet und nach verschiedenen Dimensionen visualisiert.

Ein Bericht oder Dashboard, erstellt nach Best Practice, zeigt dabei eine hohe Informationsdichte und gibt dem User aber gleichzeitig die Flexibilität auf tiefere Details zu navigieren (drillen) wenn notwendig. Wir müssen also nicht mehr detaillierte Berichte mit seitenlangen Tabellen erstellen so wie wir das früher mit Excel oder PowerPoint gemacht haben.

Neben den Standardberichten gibt es dann auch den Self-Service. Hierbei stellt sich die Nutzerin die Daten oder sogar den Bericht selbständig zusammen, um an die gerade gefragten Informationen und Antworten zu kommen. Dafür gibt es heutzutage mehrere technische Wege, z.B. per Excel Live-Verbindung auf das Power BI Datenset. Wichtig hierbei ist zu verstehen, dass letztendlich die grosse Mächtigkeit einer BI Lösung in den Datenmodellen liegt. Ist ein solches nach Best Practice aufgebaut, erleichtert das auch den Self-Service durch die Nutzer und damit ein zeitgemässes Arbeiten mit den Daten.

Beispiel interaktives Umsatzcockpit (Link zur Livedemo)

Dezentralisierung statt Zentralisierung

In der Vergangenheit wurden BI Systeme primär von zentralen IT Organisationseinheiten entwickelt und unterhalten. Mit der heutigen Technologie kann dank Low-Code eine IT- und Datenaffine Person bereits sehr weit kommen und eigenständig Datenprozesse, Datenmodelle und Berichte entwickeln. Dies ist ein sehr wichtiger technologischer Fortschritt weil es uns erlaubt den Aufbau und Unterhalt von BI Use-Cases in die Business Domänen (Controlling, HR, Sales, Logistik etc.) zu verlagern.

Damit vermeiden wir zentrale Engpässe, erhöhen die Effizienz aufgrund weniger Reibungsverluste und Schnittstellen und können die Entwicklung hin zum datengetriebenen Unternehmen beschleunigen. Was hingegen zentral bleiben muss, ist das Bereitstellen der Infrastruktur bzw. BI/Analytics-Plattform (siehe unten). Dazu gehört auch das Durchsetzen einer Data Governance, also “Spielregeln”, an die sich die Businessdomänen und Teams halten müssen.

Beispiel einer modernen Datenarchitektur mit zentraler Infrastruktur und dezentraler Use-Case Implementierung (Cajacob 2023, Link zum ganzen Artikel)

Eine moderne, flexible und marktführende BI/Analytics-Plattform nutzen

Eine flexible und funktionsreiche BI/Analytics-Plattform ist das technische Fundament auf welchem (idealerweise) alle BI und Analytics Use-Cases im Unternehmen aufbauen.

Eine solche Plattform muss in der Lage sein die gesamte Wertschöpfungskette der Datennutzung abdecken: Datenextraktion aus den bestehenden System, robuste Prozesse der Datenverarbeitung (ETL), Datenmodellierung, Datenanalyse und Datenvisualisierung.

Dabei ist es auch wichtig, dass unsere Plattform eine umfangreiche Toolbox anbietet: Die Controllerin möchte mit Power Query die Daten transformieren, der Data Scientist analysiert und verwendet die Daten mit Python Notebooks, der Data Engineer baut umfangreiche ETL-Prozesse mit Datenpipelines und die Datenbankadministratorin nutzt SQL. Sobald das nicht gegeben ist, entstehen ungewollte Schattenapplikationen ausserhalb der Plattform mit entsprechenden Schnittstellen.

Die Plattform sollte auf dem globalen Softwaremarkt eine führende Stellung einnehmen und weit verbreitet sein. Das ist insbesondere deshalb wichtig, weil ein Nutzer so schnell Lösungen für Probleme über die verschiedenen Kanäle (YouTube, Foren, Online-Kurse) finden kann. Weiterhin machen wir uns so auch das Leben bei der Rekrutierung von Talenten auf dem Arbeitnehmermarkt einfacher.

Übersicht über die Microsoft Fabric vollintegrierte Plattform

Gemeinsam in der Organisation Standards definieren und umsetzen

Wenn wir die Entwicklung und den Unterhalt von BI Use-Cases in die Business Teams dezentralisieren, müssen wir mit bestimmten Standards dafür sorgen, dass kein Chaos entsteht. Das können einfache Themen wie z.B. Namenskonventionen oder Standard-Designs für Berichte sein. Für fortgeschrittenere Organisationen werden dann die Standardisierung von Tabellen, wie z.B. Stammdaten, relevant. Damit ermöglichen wir eine Wiederverwendbarkeit von Datenprodukten in der Organisation, was eines der Ziele einer modernen Datenarchitektur ist (siehe “Data Mesh”). Und in einem sehr fortgeschrittenen Stadium fangen wir an Datenströme in der Organisation zu vereinheitlichen.

Wichtig ist, diese Standards gemeinsam zu setzen mit den Personen, welche an diesen Use-Cases arbeiten (Datenanalysten, Data Scientisten etc.), um die Akzeptanz zu fördern. Hierbei gibt es natürlich Ausnahmen, wie z.B. Cybersecurity Themen, welche von zentraler Stelle definiert und durchgesetzt werden sollten.

Datenqualität transparent machen und kontinuierlich verbessern

Datenqualitätsprobleme werden wir nie ganz wegbekommen. Wir können aber (1) entsprechende Probleme identifizieren und transparent machen, (2) eine Priorisierung vornehmen, (3) Verantwortlichkeiten definieren, (4) Verbesserungsmassnahmen umsetzen und (5) den Erfolg dieser laufend bemessen.

Mit dem Go-Live einer BI Lösung werden Qualitätsprobleme schnell transparent bzw. sichtbar auf den Berichten und Dashboards. Man kann sich sogar überlegen, gezielt ein Dashboard für die Darstellung und Bemessung der Datenqualität zu erstellen und in der Organisation zu teilen. In einem hohen Reifegrad werden sogar Kennzahlen zur Bemessung der Qualität berechnet und laufend verfolgt.

Wichtig hierbei ist einzelne Personen für die Verbesserung der Datenqualität verantwortlich zu machen. Nicht “wir” in der Organisation sind verantwortlich, weil ansonsten ist es dann doch niemand.

Ausprobieren, Lernen, Fehler machen, Vorankommen

Business Intelligence oder Analytics sind herausfordernde Themen. Wie Anfangs erwähnt müssen wir viele Elemente auf technischer und organisatorischer Ebene in Einklang bringen, um Erfolg zu haben. Hier ist es wichtig zu erkennen, dass der Weg zum Ziel selten linear ist. Es ist viel eher eine langfristige Reise, auf welcher wir mit Sicherheit mal falsch abbiegen oder über ein Hindernis stolpern werden. Wichtig ist, dass uns dies nicht entmutigt, denn es geht letztendlich allen Organisationen gleich damit. Aus Fehlern werden wir lernen und diese Learnings werden uns helfen auf unserer Reise zukünftig besser voranzukommen. Dafür braucht es eine gute Fehlerkultur, motivierte Mitarbeiter und auch ein wenig Mut.

Foto von Mark Basarab auf Unsplash